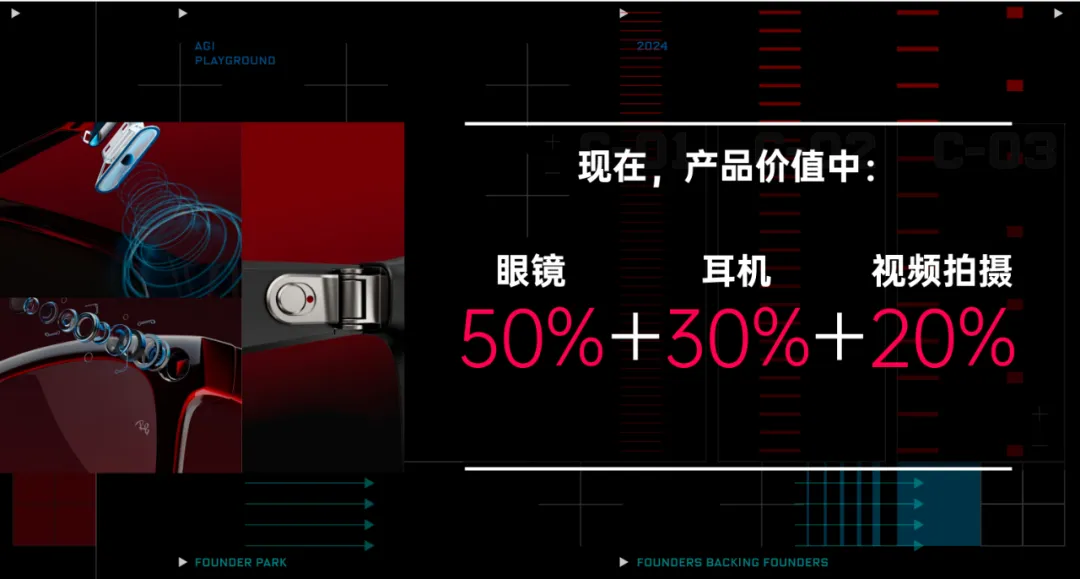

编者按:日前,启明创投投资企业蜂巢科技发布自有品牌“界环”及首款自有品牌产品——界环AI音频眼镜。界环认为做好智能眼镜的前提是先做好一副眼镜,因此,在保证听觉体验的同时,界环AI音频眼镜力图在舒适、轻量、时尚等属性上媲美普通眼镜,可以像普通眼镜一样随时随地、长时间佩戴。

蜂巢科技创始人兼CEO夏勇峰日前与极客公园创始人兼总裁张鹏展开对话,他分享了创立蜂巢科技的历程,选择深耕头戴式智能硬件的原因,以及产品研发的目标。谈及与大模型技术浪潮的结合点,他指出,开发新的AI硬件要抓住手机和笔记本使用之外的时间,开发的硬件要能随时在用户旁边,并且与用户进行交互。他表示,此次推出的品牌“界环”,倡导“融入世界而不丧失自我,取悦自己而不是自我封闭”,蜂巢科技希望能在用户的日常生活、实现目标的过程中提供帮助和附加价值。

启明创投微信公众号经授权转载。

蜂巢科技创始人兼CEO夏勇峰

除了手机之外,AI硬件最大的机会是什么?

Ray-Ban Meta销量破百万之后,AI眼镜越来越成为共识。

超过1/4的用户,每天佩戴10小时以上,每人每天媒体的平均使用时间超过7小时。“眼镜(作为产品形态)不需要证明什么了。”蜂巢科技创始人兼CEO夏勇峰说。

参与创办小米生态链的夏勇峰,亲眼见证了数百种硬件产品的诞生,他确信,“百镜大战”很快就会发生,然后迅速教育市场,接下来,“考验的一是资源能力,二是对于AI和硬件的理解力,三是一个组织的效率。”

在“界环AI音频眼镜”发布会之后,夏勇峰与极客公园创始人兼总裁张鹏进行了一场关于AI智能硬件的对话。

以下系经精编整理的对话实录。

01/

短时间内

AR硬件很难变成大众消费品

极客公园:蜂巢科技是怎样诞生的?包括你自己过去的一些经历。

夏勇峰:从我作为极客公园的一份子开始聊起吧。早些年,我是极客公园最早期的创始员工之一,后来为了圆自己做硬件的梦,在极客公园的同意下,我受邀加入了小米集团(编者注:启明创投投资企业)。

在小米集团,我最开始是做小米路由器,后来加入了小米生态链的组建。那时候,小米生态链刚刚起步,包括老板在内只有三位员工。小米生态链的成立时间是以我2014年1月8日到岗的时间为准的。我参与了小米手环、扫地机器人等一系列产品的发布,还参与创办了米家品牌。刚开始米家品牌的各种发布会其实都是我来做的。

到了2018年,小米生态链已经投了70多家公司,每年做300多个产品。那个时候,我感觉离当初做硬件产品经理的想法越来越远,我的日常工作变成了管理工作,和真正做产品已经有点距离。

极客公园知道我是一个相对比较理想主义的人,比如早年间我只想当记者,不想当编辑,要坚持在一线。所以,2018年我跟雷总(编者注:小米集团创始人、董事长兼首席执行官雷军)沟通之后,就离开生态链加入了小米手机部,开始做手机。做到2020年,我就觉得我给小米集团带来的价值也差不多了,该去实现一些自己的梦想。

于是,2020年我创办了蜂巢科技。我们有一个新的定义,就是头戴式可穿戴智能硬件,我想做这个方向的产品。可能在之后十年、二十年、三十年,我们所有的产品都会围绕这个方向来做。后来我们先后推出了眼镜、相机、米家音频眼镜等产品,包括“界环”AI音频眼镜,这是我们的一系列产品。

极客公园:2020年创立蜂巢科技时,做的第一代产品是一款眼镜相机,第二代是一款蓝牙音频眼镜,你现在在做“界环”这款产品,这之间的思路看起来也有一些变化。能不能复盘一下,这三四年你是怎么走过来的?

夏勇峰:3年时间很短,但对我来说,真的特别漫长。

我们一开始想做头戴式智能硬件,是因为当时做完手机后,发现大趋势是手机每年的全球销量都在下滑。手机质量越来越好,性能也完全足够了,所以大家的手机更换频率比以前降低了。当时我们和很多手机的重要技术合作伙伴聊,包括做屏幕的、做芯片的、做相机的,很多人都呈现出一种长期焦虑感,产业大到一定的程度之后,其实找不到新的落点。

当时我觉得,可能有手机技术溢出的机会。除了汽车,手机就应该是人类硬件皇冠上的明珠,还带来了一系列技术的持续提升,比如说低功耗、高性能、结构堆叠等等。

我就开始思考,手机技术溢出之后,有什么新的硬件产品可以承载这个趋势?

直观上来讲,如果技术持续发展,目前手持设备跟数字世界与真实世界交互的效果还不够好。长期交互,应该就是五感,这些五感通过某个硬件,比如戒指,直接去跟现实世界交互就好了。所以我觉得未来,必定有一款可能取代手机的头部设备,成为最重要的随身智能终端。头戴式智能硬件领域会涌现非常多的机会,我就把它设为了我们公司的一个超长期目标。

当时正好元宇宙处于起起落落的新一波,自然而然就想把AR作为第一阶段的产品方向,现在听起来有一点狂妄,因为AR到现在其实还没有非常好的产品。但当时我比较乐观,通过各种渠道和信息,知道好多大厂在研究AR硬件,有些大厂在立项,一些代工厂也在做各种各样的尝试。所以当时预计5-10年,AR有可能会成为主流硬件。

当时的技术还不够成熟,就先做了一款眼镜相机,它是我认为头戴的最小可运行模型。有一个近眼显示的最小屏幕,配置了足够好的相机。我做了一个相对比较完善的一体机体系,可以联网,同时还能够支持开发者在上面充分开发。系统基于安卓,但是还是有很多的调整。

这款眼镜相机确实给一些人带来了价值,但是这个产品有一个很大的问题,我觉得未来的AR眼镜短期内都无法解决,就是用户所支付的代价远远大于他们能获得的回报。可能只有有钱又向往科技,愿意为信仰充值的人,才会成为早期用户。

基本上在2022年左右,我就意识到这一点,AR很难在相对比较短的时间内,变成一个大众的电子消费品。

极客公园:今天我依然认为长期来看,AR这件事肯定有价值,但这个“长期”究竟有多长?确实是个值得探讨的问题。

你刚才提到了一个关键点,认为现在如果要做一款真正的AR设备,还是不太成熟。但随着AI的兴起,很多人认为AR可能又重新热起来了。但你今天的这款眼镜,既没有摄像头,也没有屏幕,是基于音频接入AI的。为什么不在产品里加屏幕呢?为什么你不坚持走AR的路线?在过去两年里,有什么因素影响了你的决策?

夏勇峰:我在发布会上也提到了,有些非常酷的智能眼镜在传统眼镜的基础上迈出了巨大的步伐。但我认为,哪怕是一小步,也可能带来眼镜行业的革命性变化。如果这一步走得不够稳健,那么后面的大步可能在短期内也不会出现。

比如说,我们提到了Ray-Ban Meta,这是一款相当不错的墨镜。我们也是希望努力做出一款优秀的眼镜。你可以看到,我们的产品与传统眼镜行业非常接近。正是这种接近,满足了大家的基本需求,为我们提供了一个相对较大的市场基础。

如果在这个时候,我们急于推出一款过于创新的产品,反而可能会破坏传统眼镜的基本需求。比如,佩戴可能不够舒适,或者配近视镜片不够方便,这样我们就需要去创造全新的需求,然后告诉大家,尽管眼镜的基本需求没有得到很好的满足,但我们能满足其他需求。事实上,至少在目前这个阶段,我还没有发现真正能够成立的需求。

极客公园:我挺认同你的观点,戴这副眼镜,我没有付出太大的代价。但你不加显示屏这件事,是一个挺有意思的选择。你的一代产品还是有屏幕的,这次不加屏幕背后的逻辑是什么?

夏勇峰:选择不加屏幕的核心逻辑是,加了屏幕能带来什么实际用途?首先单色Micro LED技术已经非常成熟了,但关键是,它能用来做什么?打个比方,如果你前面加了一个显示屏幕,价格贵了1500-2000元,你觉得你用它来做什么,能够让你心甘情愿地多掏这笔钱?

极客公园:现在市场上的验证是,大家拿它当显示屏,比如看视频等等,其实就是个大屏。

夏勇峰:大屏单色显示是不够的,你提到的那个更贵,1500元搞不定。现在大屏Micro LED技术还没有完全成熟,我们现在所有的商务大屏,市面上大部分知名公司用的是Broadbus的方案,那个方案成本相对可控。

最终的AR设备需要的其实是一个非常好的Micro LED技术加上衍射光波导的镜片,但这个技术还不成熟。去年有出640×480分辨率的,据说刷抖音很爽,相当于一台小电视。到明年,我估计它可以提升到1080P,但保守估计,成本至少要提高两倍以上。即便如此,我觉得它也不能很好地替代手机或笔记本。

极客公园:核心问题是,今天我付出了很高的成本在眼镜前加了屏幕,但它依旧不能全面替代手机或笔记本,所以这个时候去抢占它们的屏幕使用场景并不明智。所以这个决策并不可行,对吧?

夏勇峰:是,它只能作为一个笔记本或手机的扩展屏,就像个配件。

极客公园:如果强行让这个人自此不再用笔记本和手机,用户要付出的代价就会比较大。所以你今天反而从之前AR的路线走向了音频眼镜。

02/

Ray-Ban Meta的核心

是做好了一款墨镜

极客公园:我其实挺好奇你看到大模型领域出现后,是怎样的心情?是怎么找到跟这个技术浪潮的结合点?

夏勇峰:首先我觉得产品越接近传统眼镜,它就越能替代它们。这会带来明显的好处,因为用户的基本需求得到满足,产品佩戴时间就会非常长。如果你做出一款能替代传统墨镜的眼镜,基本上你就锚定了人们每一天戴墨镜的时间。如果你的产品特别接近传统眼镜,比如近视镜,那么产品的使用时间就会接近传统眼镜的使用时间。

我们的后台数据显示,用户使用我们产品的时间很长,前25%的用户每天佩戴超过10个小时,每人每天媒体的平均使用时长超过7个小时。这是非常长的时间。

AI到来之后,如果用户在手机或笔记本旁边,他们肯定会使用手机和电脑上的AI,用来做PPT、写稿子、加字幕、外文翻译等等。因为用户会直接在现有硬件上使用AI,所以我们开发新的AI硬件,要抓住手机和笔记本使用时间之外的时间。开发的硬件要能在用户旁边,并且与用户进行交互。

极客公园:你的意思是,今天不应该去尝试抢占手机和笔记本的使用时间,那是不可能的。相反,我们应该在它们之外找到对用户有价值的事情,并且这种价值足以让用户愿意长时间佩戴。比如VR眼镜就不行,通常只在看电影时佩戴,之后我们就摘下来了。所以这个产品是推理出来的吗?

夏勇峰:那也不是。最初我们是先开发了音频眼镜,后来AI技术兴起,我们就发现AI非常适合这种产品,特别是在用户不在使用手机和笔记本的时候,比如开车、骑行或跑步等场景,通过音频眼镜使用AI是一种更自然的方式。如果他们在这些时刻需要AI,可能可供选择的硬件很少。除了眼镜,我认为还有两个设备非常适合集成AI,那就是汽车,还有手表或高续航的手环。在特殊场景下,人们无法使用手机或笔记本,这些设备就能发挥作用。

极客公园:手环和手表传递价值的方式可能只能是振动,发出声音感觉不太合理。眼镜的位置我觉得比较好,因为它可以耳语,这就很合理。

一个大家可能都很关心的问题是,现在很多人觉得Ray-Ban Meta眼镜不错,前面有两个大大的摄像头。之前讨论了为什么不加屏幕,那你觉得未来你的眼镜会加摄像头吗?这一代没有摄像头,未来会有吗?你是怎么考虑的?

夏勇峰:我也知道现在市面上其实有很多人在做类似的,无意冒犯大家,我讲讲纯个人观点。我认为Ray-Ban Meta的核心是做好了一款墨镜。

它是一个与人的社交距离较远的设备。在一些地广人稀的地方,你在墨镜上加一个摄像头,不管用来做什么,至少是合理的。在远处人们佩戴一个摄像头不会对别人构成冒犯,但如果在人口密集的地方,每天佩戴着搭载摄像头的产品,从早到晚。我试过,感觉非常尴尬,给别人带来的社交压力,会回到我自己身上。

极客公园:从别人的眼神里你能观察到,他们觉得这款产品有点可怕。

夏勇峰:对,所以我认为加摄像头的AI眼镜,和我们现在做的AI音频眼镜本质上是两个完全不同的产品。

摄像头AI眼镜更适合在一些短时场景里给用户提供更高的价值,但具体能提供多少,还得看后续的发展。它替代墨镜还可以,但大部分中国人其实是不戴墨镜的,外国人才戴。这不是武断,是从百分比来看的,中国的近视人群相对较多,如果他们要戴墨镜,要么就是戴隐形,要么就是配一副带度数的墨镜,或者戴一个套镜,但总体来讲,墨镜的总量百分比远低于欧美。在美国很多地方墨镜是刚需,是每个人必须要买的产品,在这个时候AI眼镜替代墨镜,群众基础会比较好一些。

墨镜天然适合加摄像头,AI又需要摄像头,这个故事就闭环了。

极客公园:如果按照这个逻辑来看,你今天选择的道路并不是从墨镜的角度出发,而是我们日常佩戴的眼镜,对吧?它本质上就是我们日常所佩戴的镜框,只是换成了近视眼镜,这样确实能有效解决问题。

既然我们谈到了AI,现在大家都很关注AI领域,从去年开始,AI已经从纯语言模型发展到了更加多模态的阶段。AI的演进意味着如果你有摄像头,你就具备了多模态的能力。你可以通过视觉去理解很多事情,进而帮助解决很多问题,比如看到某个内容能翻译成英文,或者识别出这是什么,这本质上就像是摄像头变成了传感器。所以产品如果加上一个明显的、用于拍摄视频的摄像头,这已经变成了另一个品类。

你现在的产品是智能音频眼镜,如果未来要运用AI实现多模态,增加传感器是否必要?在什么情况下会考虑增加?

夏勇峰:我确实考虑过这样的问题,甚至和一些大公司探讨过制作demo的可能性。我认为可能有两种方式。

第一种方式是,摄像头前面的镜片通常是玻璃的,你可以把它做成电子变色的,由AI控制何时需要开启。平时它就像是“闭着眼睛”,需要时就“睁开眼睛”,这样或许能缓解一些隐私问题。另一种情况是,你带一个摄像头,AI能分辨图像,但不能拍照,也不强调画质,并且要让所有人都知道这不是用来拍照的,而是一个传感器。因为AI需要的分辨率并不高,600×400的分辨率基本上已经够用了,不需要像Ray-Ban Meta那样高分辨率的摄像头和高级芯片,以及加载那么多拍照算法。

极客公园:所以,如果从智能的角度来看,确实有必要加入有效的传感器,但这一代产品还没有加。我相信你肯定在这方面做了技术储备,刚才提到的加“眼皮”,或者明确告诉大家这是传感器,没有拍摄功能,只是识别,才能解决隐私问题。我觉得很有道理。

夏勇峰:需要考虑在人群密度较高的场景下,能否正常无障碍地使用它,这可能和它本身实现的功能同等重要。

极客公园:那么,如果这种传感器加入之后,这副眼镜会实现一些超越我们想象的能力吗?

夏勇峰:可以稍微透露一点。与其说它能实现什么具体功能,不如说它能让AI更加了解人的意图。我们之前讨论过,未来可能是AI接管一切,你只需要做自己,因为AI机器非常聪明,当你做自己的时候,AI基本上就能知道你想要做什么,你的意图是什么。它可能会取代一些现有的图形用户界面(GUI)的功能。我认为它能够帮助机器更好地识别人的意图。

极客公园:所以,它实际上是一种用于识别意图的传感器,我们不应该将其理解为传统意义上的摄像头拍摄功能。这一点可能是核心。

03/

先做好一款好用的音频眼镜

然后加入AI

极客公园:加入了AI之后,这一代产品有哪些特点?会带来哪些与之前音频眼镜不同的体验?

夏勇峰:我们其实设定了目标。第一是要做世界上最好看的眼镜,颜值即正义。第二,我们要做世界上用起来最舒服的眼镜。第三,我们要做这个世界上最聪明的眼镜。

第一个目标:最好看。我们的眼镜像传统眼镜一样有很多框型,8框14色,能够有效提升颜值。

第二个目标:最好用。我们已经开发了三代音频眼镜,这一代在实际使用体验、人体工程学设计以及镜框方面都有明显的提升,最轻的只有30.7克,整体佩戴舒适度都有显著提高。为了制作优质的眼镜,我们还提供定制镜片服务。如果你不确定要购买什么样的镜片,可以直接在我们这里购买眼镜并配镜片,确保性价比。

我们的变色镜片在室内可以防蓝光,在室外则自动变为墨镜,能防紫外线,当然也相对贵一些。现在镜片已经正式纳入了我们的眼镜业务,会统一给大家提供相关服务。

第三个聪明,其实就是说AI。

极客公园:讲讲AI吧,你的AI音频眼镜叫智能眼镜,这个智能体现在哪里?

夏勇峰:我们的AI,你可以将其简单理解为是语音助手的升级版。从ChatGPT开始,到现在我们的国产AI模型,在大众端还没有出现非常核心、为大众带来显著价值的应用,但它拥有无限的可能性,基本上能够实现从文本到文本,语音到语音的转换,这是AI从1.0到现在能够为大家带来的功能。

对我们来说,什么是语音助手的升级版呢?

当你向它提出一个问题后,它能够识别出你的意图和不同需求,并将这些需求分配给不同的AI代理(agent)去执行。执行完毕后,再汇总回答给你。我们称这些不同的AI代理为“AI小人”,它们在你的眼镜后面不停地为你工作。比如你说:“明天我想听听法国媒体对奥运会的评价,请在明天晚上8时前给我一个总结。”听到的AI小人就会告诉工作小人:“你明天要产出这个内容。”第二天晚上8时,工作小人会把总结交给负责与你对话的小人,然后这个小人会念给你听。

与你对话的小人,我们称之为VUI,即基于语音的用户界面。当基于语音的交互因为AI能产生越来越多的价值时,它就会变成一个交互界面。这是利用AI核心目标的一部分,我们希望在跨平台上让用户拥有一个统一的VUI体验。

极客公园:我尝试理解一下,如果要说这副眼镜带来的根本性改变,那就是通过它,你能够调用无所不能的AI,围绕你的目标去解决问题,通过这个眼镜用语音的方式给你完成合适的任务。

背后的技术是大模型,也就是你用语音就可以调动AI,这是交互的核心节点。我们不用像原来拿着手机一样,跟手机发消息,我觉得这个是关键的改变。

夏勇峰:如果看背后的架构,我们是通过眼镜以及与眼镜长期连接的手机App进行第一道处理,处理完后,再将用户的日常生活习惯与服务器上的需求进行匹配。

在我们的服务器上,有预设的prompt,还有AI Hub,它连接着许多服务,当然还有很多AI agent。我们会整体打包,指导它找到适合处理这个事情的大模型,大模型完成工作后结果返回服务器,再通过手机端返回到眼镜上,基本上的工作逻辑是这样的。

极客公园:有人说这类似第一代小爱,现在用上大模型,有什么优点?

夏勇峰:关键是,第一代小爱发布的时候,根本没有大模型。

极客公园:小爱其实并不具备今天我们说的这种无所不能的能力,对吧?

夏勇峰:举个例子,我们有一个功能叫做AI通知播报。比如我在飞书上收到了同事发来的图片,如果是传统的通知播报,它没有任何能力告诉你具体内容,你只能掏出手机来查看飞书。

现在有了AI通知播报,我还没掏出手机,就听到信息:“xxx刚才给你发了一张图片,可能需要你确认。”这就是AI通知播报的一个例子。当然,我们同事也在考虑,是否加入图像识别,但目前我们还没打算做。

还有一个例子,这是我真实遇到的情况,有时候你会突然被拉进一个微信群,在设置免打扰之前,这个群会一直发出通知声。如果你戴了这副眼镜,你不必立刻查看并回应,甚至不用掏出手机,AI会先自动给你一个小结。如果你发现确实与你相关,再进行回复。AI为你提供了一层筛选,确保你不会错过重要信息,同时也不会被信息过度打扰。大家现在不得不经常查看手机,一看到微信通知就得解锁手机。使用AI后,这样的动作大大减少了。

有些人可能认为这不是刚需,但根据我们之前的数据统计,打开通知播报的用户比例非常高。我们之前有近10万用户,超过36%的人开启了通知播报,即便通知播报有非常多垃圾信息,但他还是打开了。这个确实是一个挺高频的需求。

极客公园:我在发布之前用了测试版,一上来就发现有通知播报,就打开了微信和飞书这两个App的通知播报。我发现它不是简单地把那个通知给我念一遍,其实会做一下概括,我后来发现这一点很好。

这个功能,反而让我更及时地收到信息,以前我是隔一个小时打开手机看看有什么事,通知功能对我没用,因为我手机都不放在身边,我也不看,但现在可能有一些比较紧急的事,我可以快速响应。

经常有人给我发对话的截图,发图是想给我一些背景信息,让我看看他们是怎么聊的。未来要是能帮我把图识别了,直接帮我总结一下,我就不用看截图里的对话了,那我会非常期待。

夏勇峰:不过识别图片会有新的问题,它属于多模态识别,我们还在讨论,还没有确定要加这个功能。但是AI通知播报我们已经优化了两个月,现在可用性其实蛮高的。

极客公园:如果让我推荐一个功能,肯定也是通知播报。我用了大概一周,感觉在这种比较智能的总结播报中能明显感觉到AI的作用。未来甚至可以让它去生成简报,把我要看的内容都先概括一下。

我现在用得比较多的是AI通知播报功能,可能未来还会有新的功能。可以给我们透露一下可能的新功能吗?

夏勇峰:年底我们会推出“界环爱听”,AI cast这个功能。因为我们有很多的用户都是重度的耳机用户,或者说重度的音频内容消费用户。举个例子,我们的用户里听小宇宙和喜马拉雅的用户占比是非常高的,远高于互联网的平均占比,他们是重度播客用户,经常会一边听播客,一边干其他的事。

我们做了一款短音频的应用。但是它和短视频应用最大的区别就是,它不需要那么多的UP主,不需要那么多的真人,每一个UP主都是一个AI小人。比如说,有一个AI小人专门给你讲东周的历史,有一个小人专门给你讲三国,有个小人专门给你讲笑话,也有小人专门去总结新闻,像这样的AI小人会非常多,我们会关注到播客里有哪些内容是比较受欢迎的。

极客公园:就是用agent替代了所谓的UP主,对吧?

夏勇峰:对,它跟短视频的区别在于,我们的短音频的时间会稍微长一些。生成内容之后有一个AI小人当内容审核官,质量差的打回去改,质量好的就放出来。

刚开始的数量可能会少一点,目前我试用的这个版本每天大概只有20个左右的短音频,但是未来它会有很多。用户使用它就像听播客一样,不感兴趣,往后滑,它就跳到下一个,觉得又不感兴趣,再往下滑,当你滑得足够快,你就会发现你讨厌的内容渐渐不会出现在你的“界环爱听”里面了,然后它逐渐就会知道应该给你放什么。这是我们会在今年冬天上线的一个功能。

极客公园:有人问,是觉得UP主还不够多,还是AI比人强?我说一下我的理解,这些agent本质上是要更无限贴合用户的需求,倒不是说UP主不够,也可以理解为完全跟你贴合的UP主是不够的,但不一定说是AI比人强。因为UP主再多,也是你在寻找能够匹配你需求的UP主,而且也不是真人UP主的每个作品你都觉得特别好,人家也不会只为你创造内容,但这个AI agent是只为你创造内容。

所以我觉得,理论上如果这些平台有API,你其实也可以直接去听那个UP主的内容,UP主内容也是可以接进来。但是如果觉得不够匹配,AI可以再围绕你的需求去生成内容,那这个其实就叫真正的大规模个性化。

夏勇峰:如果觉得这个功能不好,还可以听小宇宙,我们就当一副音频眼镜用。如果觉得这个功能好,你就会用。我们逐渐会把它越做越好,因为毕竟我只需要AI小人,我不需要UGC。

极客公园:这个挺好,用户只要先戴上,使用通知的功能,觉得挺好就长期戴上了。若告知用户有短音频功能,如果我本身就有短音频的消费习惯,那可能就用上了。一开始就是消费一些原来认识的UP主,逐渐发现,如果不够还能生成。这就是滴水穿石,缓慢渗透。

04/

不是接了API就叫AI智能硬件

极客公园:真的把大模型塞到硬件里去,还是要做一些基础功能的,比如怎么搭架构、怎么用。AI语音播报这个功能的背后,架构怎么搭的?是端侧有模型吗?还是都是在云端?为什么不直接调小爱大模型?

夏勇峰:我们现在眼镜没有端侧大模型,其实也没有必要。一定程度上我们参考了Meta的一些做法,就是通过眼镜加手机的App端,一起去做第一道处理。如果未来手机开放了一些大模型语音的能力,包括分享、通知的权限,甚至NPU,可以让我们在上面跑一个小模型的话,肯定会部署端侧的。为了加快本地的处理速度,实现更多的功能。

但现在还没有,现在我们是通过App直连到服务器。首先在App端做了基于语音的一些分析,包括TTS、ASR、音色。在服务器端,与用户对话的agent的性格、情绪都是用户自己设定的。第二是RAG,第三是AI Hub,我们连了十几个大模型。我们还有一个AI长期记忆的功能,也就是有更长时间的历史信息的上下文,由此来更准确地判断你的意图。

把这些实现了之后,我们还做了内容质量审核AI,提交给用户的内容质量过关了才能发给用户。同时,我们在服务器端还做了关于大模型调度的prompt,把它交给大模型,然后再回来做一些类似的工作,最后推到手机端,推到眼镜端。

极客公园:所谓的AI智能硬件,如果只是接个API,是不能交付足够好的结果的。它确实要站在用户价值上,要做一套比较完整、合理的架构,然后去合理地调用。

你们已经涉及到不同模型的调用,甚至涉及到更长期的记忆如何存储、如何调用、如何配合。在不同场景、交付不同的价值等情况下,可能都要考虑怎么去更合理地运用AI,这个我觉得会成为未来AI智能硬件里很重要的一点,它真的不是只接个API就能解决的问题。

因为我最近看了好几个产品,说“我是AI硬件”,“接了某某的API”。这个不能叫AI硬件,不能很好地解决问题。

为什么花了很长时间在探讨怎么定义这个产品?很重要的一点是,夏勇峰不认为这副眼镜能替代手机,他其实是在手机的边缘,来交付一个更好的体验。我觉得这个是核心点,因为刚才我们说到很多功能,其实手机就能实现。

但有一点很重要,前端的指令和意图是通过眼镜来的,而不是收入到手机里,也不是直接跟手机对话。交互的时候,用户不需要拿出手机,音频就能交互。这就是刚才你说的VUI。

我们理解GUI,刚才你也说到VUI,还说到NUI,这本质上就是未来的交互。未来的交互和交付并不是要替代手机和电脑,但是它有可能会增加一种更接近用户自然体验的交互和交付,交互和交付都因为它会有所不同。你怎么去定义和理解所谓的GUI、VUI、NUI?

夏勇峰:GUI其实就是我们熟知的图形用户界面,当时对计算机来讲是一次非常重要的革命,因为要让机器知道人想干什么,其实是一件很困难的事。计算机早期的汇编语言都是非常标准化的,这个时候规定了一种范式,后来就到了智能手机时代,但是它其实仍然是一种范式,比如说屏幕,你需要告诉这个机器,你点到哪了。这就是为什么早期有一些老年人,使用智能手机其实有很高的门槛,因为还是需要学习,虽然学习的成本比学文字输入、学QWERTY的键盘要简单一些,但它还是有门槛。

未来整体的交互,很多朋友都认为,会进入一个NUI自然用户界面。你只需要做自己就好了,该说什么话说什么话,该做什么动作做什么动作,机器变得越来越聪明了。

你做自己,机器就知道你想干什么,然后就给你相应的服务,这个是我们认为未来的交互,它可能形成了一种形态,特别是在通用大模型出现之后,可能我们没办法很快出现通用人工智能,但是让机器能够识别到你的自然行为,这件事情会容易很多。

我认为这个也是我们未来眼镜要实现的一个目标,当然同时也是因为,如果想在眼镜上用键盘打字,或者要用触摸操作,这基本上也实现不了。

极客公园:举个例子,假如说我旁边有个助理,我用手指这里,跟助理说“把这个关掉”,这是我们正常的情况,但如果在今天我要去跟小爱同学交流,我恐怕还得说“小爱同学,把我卧室里的空调往下调低多少度”。

但理论上,未来如果你有这样的一个设备,假定它是能够开眼看世界的,有一个传感器,我说把这个关掉有点冷,它应该就能识别我在哪个空间,同时知道我说的是空调,我不需要去指出具体的要求,这是我具象化一下你说的那个场景。按照这个推理来讲,我越来越觉得,真的不考虑加上摄像头输入交互吗?

夏勇峰:摄像头看了之后,如果还是需要自己去输入指令给机器的话,其实还是VUI,但是机器有一个摄像头,可以减少你的输入成本。

极客公园:就像我说,“把这个关掉”,而不是说“把卧室的空调下调几度”,这个其实就降低了我的输入成本。这个摄像头本质是意图传感器,我猜未来肯定会加的。

夏勇峰:我先把VUI做好,其实对我来说VUI是NUI的一个前置阶段,VUI做好的价值就非常大了。

05/

AI不会凭空创造需求

只能无限提升体验

极客公园:耳机看起来也是可以应用VUI的。为什么你做的不是耳机,而是眼镜呢?

夏勇峰:我觉得耳机跟墨镜基本上是一类产品。用户不是每天无感的,或者从早到晚戴,它是一个有了需求才会戴上,需求结束马上摘掉的产品。VUI需要有很多交互,当你需要用这个交互的时候,它可能根本不在你的耳朵上。

极客公园:本质上还是用户使用时长不够。

夏勇峰:你不可能戴一天的耳机,否则走路很危险,开车也用不了。

有人问我们,为什么不做充电盒?因为我们没有“不用了就把它摘下来”这样的一个场景。如果是耳机不用了,你会把它摘下来,放到充电盒里,它可以继续充电,这是很自然的。但是眼镜就得用一天,所以我们的续航一定要能用一天,不可能说,我是一个近视的用户,下午2时就把它摘下来了。

对AI来说,有主动发出指令,也有被动收到AI通知的场景。比如说通知,主动给你小结的这种,当你耳机在充电盒里的时候,没有任何作用,但是如果戴的是一副眼镜,基本上每天是无缝无感地在使用,这是它最大的一个区别。

极客公园:这个视角也对,我觉得要从让用户能戴上且能长期戴上出发,才能让AI在需要发挥作用的时候真的能起到作用。不能把它变成一个“目的地”型的产品,什么时候要用AI了再戴上。所以第一要义就是大家戴上。

这个设备终于不用再提醒我,你戴了一个智能设备。它出现一些耳语的时候是给到我惊喜的,因为我觉得就是戴了个眼镜而已。

这里也涉及到一个考虑,它叫智能音频眼镜,很重要的一个功能也确实就是耳机的功能,所以你到底是在革新眼镜还是在革新耳机?

夏勇峰:我们有一句slogan叫“科技革新传统眼镜”,因为我们之前的用户里,89%都是矫正用户,即近视或者老花用户。他们用了这个眼镜之后,如果是长期戴眼镜的人,基本上是近乎100%替代了自己平常使用的传统眼镜,传统眼镜就变成了它的备用镜,所以它的替代性是很明显的。

但是我们其实没有替代耳机。因为现在对耳机有很多需求,比如说想安静的时候,有降噪的需求,我们做不到。打游戏的时候有低延时的需求,这个我们未来可能可以做到,但是现在肯定没有游戏类的专业耳机好。比如说客服戴的耳机,需要一个离嘴非常近的麦克风。总之就是,耳机的多样性非常多,不可能用我们这样一个音频类的产品就能覆盖所有的耳机需求,但是基本上覆盖了他们眼镜的需求,这个是数据统计的结果。

极客公园:有道理,而且如果真的要让科技革新传统眼镜,我就能理解为什么需要考虑很多不同的款型,不能说一出门,发现大家怎么戴的都是一个款型的眼镜。

夏勇峰:传统眼镜的历史已经证明了,单一款型不奏效。

极客公园:所以它其实是需要更多个性化的选择,但同时又要做到让大家先能戴上,而且长时间地戴上。

这一点我觉得还挺重要的,我们判断互联网的一款产品在未来有没有进一步发展的能力,核心就是用户的使用时长。

如果这副眼镜我一天能戴10个小时,随着未来传感能力不断升级,对我意图的理解更彻底,那它能帮我干的事一定会更多。如果一天只拿出来用三次,这个硬件我觉得没前途,就是卖点硬件的钱,甚至模型、所有的功能都无法成长。

所以有可能存在这么一个点,我可能说得有点武断,就是未来AI智能硬件的佩戴时长得三五个小时起步,否则可能还是卖了个AI噱头,没有真正长期的成长性。

夏勇峰:AI硬件就是使用AI的硬件。总体来说,人们从早到晚都在用的有两大巨头——电脑和手机,产品首先要从两大巨头之外找到自己生存的空间,在这个空间里,它要成为大家使用AI的第一优先级,这个可能是最基础的生存条件。

极客公园:今天得到的一个启发就是怎么去看AI硬件,有一个很重要的维度,就是到底是拿AI当卖点去卖硬件,还是硬件未来能顺着AI的能力持续成长,释放更大价值。这个核心的分界点就是,用户到底有多少使用时长,要做到这一点,就得先解决用户的某个确定问题,把它解决好,才可能会有这个资格。

夏勇峰:我也做了几百种不同的硬件了,越来越感觉到,人的需求能够不断地被满足得更好,但是想要创造一个需求其实是非常难的。我觉得AI不会凭空给人创造一个之前本身就不存在的需求,它只会让人的某些需求能够被满足得更好,或者是提高某些效率,或者是让人听什么内容听得更爽,看什么内容看得更爽。

以前某些场景下满足不了的需求,现在因为AI可以满足了,基本上只能是对需求的进一步满足,不太可能出现之前不存在的需求。比如说需要一个外脑,天天在你旁边分析你每天从早到晚的事情,我觉得它太宽泛,或者说太理想化了,它得具体到人本身的需求。

可能这一点我也有一些武断,我觉得需求只会被满足得更好,但是不可凭空创造需求。我发现某一些AI硬件,它觉得有了AI可以凭空创造出之前不存在的需求,这一点我持比较谨慎的看法。

极客公园:Ray-Ban Meta的这副眼镜,大家之所以这么关心,核心就是,这是所谓的科技眼镜产品中,第一个卖过百万台的,除了之前VR这种被大平台推荐的产品,这是用户自己主动去买的设备。你会怎么判断它未来可能的走向?

自己内部肯定也分析过,今天国内至少有几十家公司要复刻Ray-Ban Meta。它之所以具有这个所谓的阶段性成功,是因为什么?它未来的发展会遇到什么样的挑战?会有可能往哪走?

夏勇峰:海外有一些关于Ray-Ban Meta的用户调研报告,超过40%的用户对它的第一诉求其实是第一视角拍摄的视频质量过关,而不是AI。

极客公园:肯定不是,因为它出来的时候还没有什么AI相关的产品。

夏勇峰:然后我们再注意到,有很多用户,其实首先是需要一副墨镜,Ray-Ban又是一个足够好的牌子。我有个朋友跟我说,他走进了一家Ray-Ban的店,需要去买一副墨镜,他发现有普通墨镜和Ray-Ban Meta,中间的差价非常少,应该是在几十美元这样的一个程度,一个是传统的,一个带了很多功能,然后用户就选了Ray-Ban Meta。

极客公园:所以科技几乎是赠品对吧?是一个让你觉得很合算的赠品,有点这种感觉?

夏勇峰:反正我是觉得,因为AI去买Ray-Ban Meta的人,在目前的用户群里应该是相对少数。如果没有AI,它做了一款非常好的智能墨镜,我觉得也能卖到跟今天相差不远的数量。

极客公园:所以它其实并不是因为AI才火的。本质上是一个好的品牌,然后加了科技感和一些有意思的功能的产品,大家一看差价也不太多,原来买个普通Ray-Ban也得这个钱,那就买了。

夏勇峰:但是话说回来,如果AI持续升级,它有可能从现在的第二卖点上升,直到某一天基于它的用户群免费(眼镜的AI使用是免费的,没有订阅费),它变成了一个非常高价值的点,这个时候它可能会完成从一个足够好的智能墨镜到一个真正的AI眼镜的转变,这是有可能会发生的。

极客公园:同意。在今年Founder Park的AGI Playground上,我曾经做了一个演讲,专门分析了Ray-Ban Meta眼镜为什么成功,探讨了在硬件上的一些机会。

其实我的观点跟你很一致,我也认为最开始的核心的卖点绝大部分来自于眼镜本身。但它未来的价值,可能70%会来自于AI。

06/

越是无限可能

越要约束自己的想象

极客公园:如果从我的视角来看,这个产品放在海外,大家就会觉得你不够猛,比如,怎么可能上来不加传感器呢?但是我觉得你会关注的是,它怎样成为一个稳定的、能交付、能满足用户需求的产品,用户不用为我的创新付出过大的代价。先让大家戴上它,解决问题,然后软件和AI是可以往上叠加的,功能是可以越做越多的。

再追问一下,今年一开始火起来的AI Pin后来也遇到了很多吐槽,它的问题到底在哪?

夏勇峰:它实现不了想要的那个感觉,如果硬件概念更多一些,就会知道,不管是投影还是固定的方式,根本不能够支撑它作为手机备用品的定位,投影就得有流明的概念,就会设想它在室外和室内的使用问题,其实通过非常简单的一些数据和参数的推导,就会知道这个产品存在问题。

极客公园:在2013年初,我们俩一起去见张小龙(编者注:腾讯集团高级执行副总裁,微信事业群总裁),被他启发过。当时我们聊到一个结论,那时候微信看起来有非常好的势头,他说:“越是无限可能,越要约束自己的想象。”你看微信今天已经成为了能干这么多事的产品,但在那个时刻,其实我们跟他说了无数个,你可以干这个,也可以干那个。

他就是特别沉静,不着急,一步一步地来。我突然想起了这个场景,这个让我回忆起来还是印象蛮深的。所以AI智能硬件这件事还真的要一步一个脚印的来。

据我所知,中国已经有大量团队在这种所谓智能眼镜领域里聚集了,你怎么看?是不是很快会有百镜大战了?在这里,最终要能够活下来,能够创造更大的价值,你会觉得核心是考验什么?

夏勇峰:我知道的创业团队和一些公司的项目中,大部分类似于Ray-Ban Meta,然后也有一部分是基于现有的一些智能眼镜,直接往上加摄像头的,你知道它能够帮你识别内容,但是大部分人其实就是问一下这是什么,然后得到一个回答,尝尝鲜。

可能是我了解不够,现在我还没有看到更深入的一些应用。我觉得未来的百镜大战会迅速产生,然后教育市场,会出现非常快速的淘汰和迭代的过程。

极客公园:涨潮快退潮也快。

夏勇峰:如果出现真正创新的产品,它的崛起也会非常快。不会给慢性子的人留时间、留空间。所以我觉得,考验的一是资源能力,二是对于AI和硬件的理解力,三是一个组织的效率。基本上就是考验这几点,以现在我们所知道的信息,类似这样的局面应该在不久的将来就会到来。

极客公园:我们说百镜大战在路上,但是可能也是一场快速的战役,记得当年无人机曾经也有过一波热潮,后来就消退了,今天应该是很多人都在关注、在做,但把这事做对、做到位,变得很关键。

最后我再追问个问题,蜂巢科技在界环这样的品牌下,未来想实现的是什么目标?你阶段性想实现的目标到底是什么?你觉得大概会用多长的周期去实现它?实现的时候可能会是什么样?

夏勇峰:所谓界环,就是世界之环的意思。什么叫世界之环呢?就是自我和世界,他人即世界,你自己和世界中间的界限,我们想要倡导的理念是“融入世界而不丧失自我,取悦自己而不是自我封闭”。

为什么不做VR,是因为我觉得VR是一个把自己完全封闭起来的产物。我希望在日常生活、实现目标的过程中,它能够帮助你,给到附加价值,我希望做这类产品。所以眼镜相机和现在的音频眼镜,其实目标是一致的,就是有自己的目标,然后不要封闭,但是也不要丧失自我。

我希望现在第一阶段实现的目标就是,音频眼镜能够以每年两倍、三倍销量的增速去替代传统眼镜。今年实现了这一目标,我觉得明年大概率也能实现,用3-4年的时间,每年超过100万副,我觉得它会迎来一些质变。目前我的核心还是在满足传统眼镜需求的同时,逐渐去对传统眼镜产生一些替代性的作用,能够在每个人的耳机使用时间上占到比其他类型耳机更多的时间。

极客公园:很清晰。我觉得一个优秀的创业者往往是能够在无限可能的时候约束想象,把每一步走扎实。聚焦这个阶段是什么问题,然后把它解决好。因为技术永远能给你带来无限的可能性,只要你把这个产品做扎实,那这些新的功能永远不缺。但容易犯的错误是,一上来说了一款恢弘的产品,但忽略了该做好的基本功。尤其是在硬件上,软件还可以改代码,但硬件就没机会了。

来源 | 极客公园